강화학습은 "어떤 행동을 해야 가장 좋은 결과를 얻을까?"를 배우는 방법입니다. 그런데 복잡한 상황에서는 행동을 하나하나 모두 따져보는 게 어렵습니다. 이럴 때 등장하는 것이 "정책 경사법(Policy Gradient)"입니다.

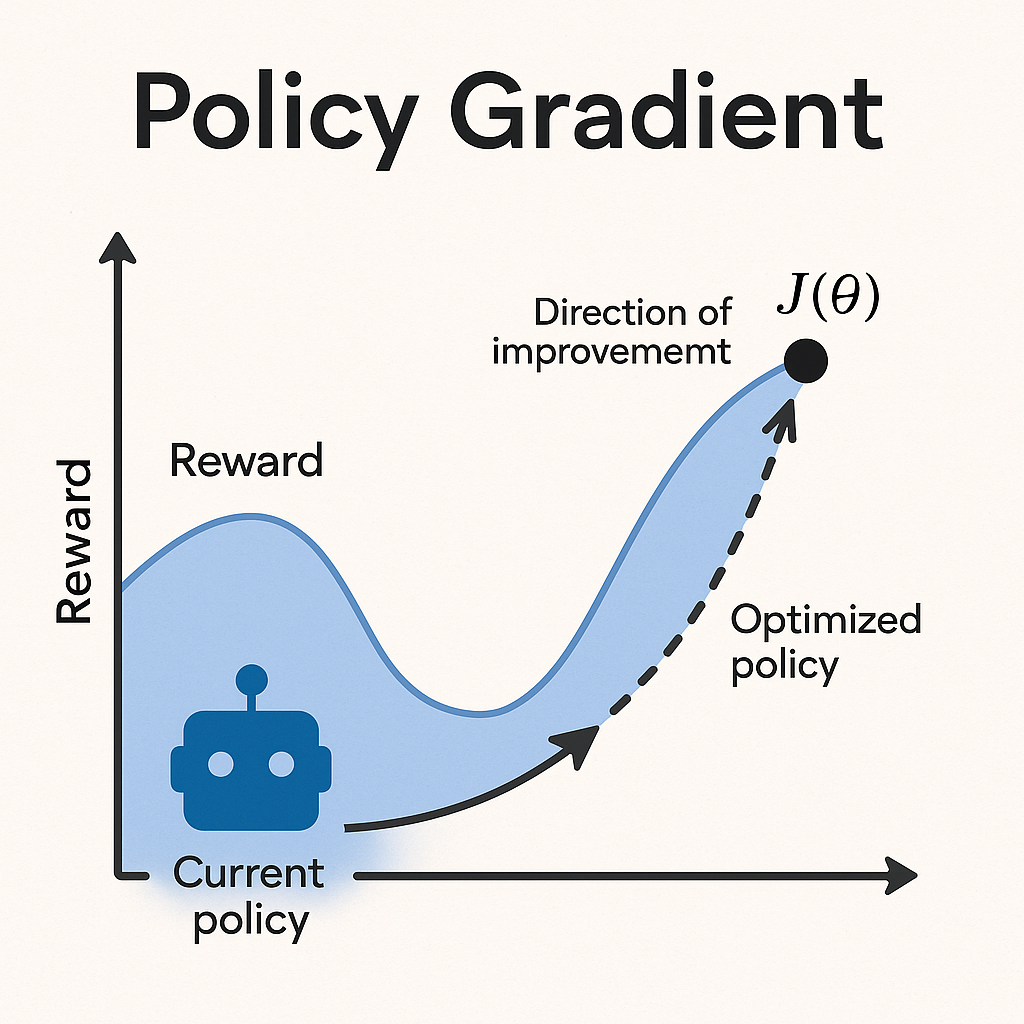

정책 경사법은 간단히 말해, "좋은 행동을 더 자주 하도록 정책(policy)을 조금씩 조정하는 방법"입니다. 여기서 정책이란, 주어진 상황에서 어떤 행동을 할지 결정하는 방법(또는 확률 분포)을 뜻합니다.

- 정책: 어떤 상황(state)에서 어떤 행동(action)을 할 확률을 정해주는 것

- 경사(Gradient): 현재 정책을 조금 더 좋은 방향으로 바꾸기 위해 필요한 조정 방향

정책 경사법은 정책을 직접 조정하면서 학습합니다. 좋은 행동을 했을 때는 그 행동을 더 잘하도록 정책을 강화하고, 나쁜 행동을 했을 때는 그 행동을 줄이는 식입니다.

정책 경사법의 의의

- 복잡한 문제 해결 가능: 행동이나 선택지가 무수히 많은 경우(예: 로봇이 복잡한 움직임을 해야 할 때), 기존 방식(Q-러닝 등)으로는 다루기 어려운데, 정책 경사법은 이런 문제에 강합니다.

- 확률적 정책을 다룰 수 있음: 정책 경사법은 확률적으로 행동을 정할 수 있어서, 매번 다른 행동을 시도해보며 더 좋은 전략을 찾을 수 있습니다.

- 연속적인 행동: 자동차 조향처럼 연속적인 값(0.1도, 0.2도 조정)이 필요한 문제에서도 자연스럽게 적용할 수 있습니다.

주요 성과

- REINFORCE 알고리즘(1992): 정책 경사법을 이용한 대표적인 초기 알고리즘입니다. 좋은 결과가 나오면 해당 행동을 강화하는 단순하지만 효과적인 방법을 제시했습니다.

- Actor-Critic 방법(1990년대 후반): 정책을 업데이트할 때, 별도로 가치 함수(critic)를 함께 학습시켜서 학습 효율을 높이는 방법입니다. 이후 강화학습의 핵심 기술 중 하나가 되었습니다.

- Proximal Policy Optimization(PPO, 2017): 정책을 너무 급격하게 바꾸지 않도록 안정적으로 학습하는 방법으로, 현재까지도 가장 널리 사용되는 강화학습 알고리즘 중 하나입니다.

강화학습 발전에 끼친 기여

- 복잡한 환경에서의 강화학습 가능성 확대: 예전에는 강화학습이 단순한 게임이나 문제에만 적용되었지만, 정책 경사법 덕분에 로봇 제어, 드론 비행, 복잡한 전략 게임 등에도 강화학습이 적용될 수 있게 되었습니다.

- 심층 강화학습(Deep Reinforcement Learning)의 핵심 기술: 오늘날 딥러닝과 강화학습을 결합한 많은 연구들은 정책 경사법을 기반으로 하고 있습니다.

- 알파고(AlphaGo): 딥마인드의 알파고 역시 정책 경사법을 활용해 바둑 수를 결정하는 정책망을 훈련시켰습니다.

정책 경사법(Policy Gradient) 세부 알고리즘

정책 경사법(Policy Gradient)은 에이전트가 최적의 정책(행동 전략)을 찾기 위해 정책 자체를 직접 업데이트하는 방법입니다. 이 방법은 특히 행동이 이산적이지 않거나, 최적 행동이 명확히 정의되지 않는 복잡한 문제에 강력한 성능을 보입니다.

이번 글에서는 정책 경사법의 대표 알고리즘(REINFORCE, Actor-Critic, PPO)과 각각의 세부 원리 및 활용 사례를 초보자도 이해할 수 있도록 자세히 설명합니다.

1. REINFORCE 알고리즘

원리

- 정책(Policy): 각 상태(state)에서 어떤 행동(action)을 할지를 확률적으로 선택하는 모델입니다.

- 업데이트: 한 에피소드(시작부터 끝까지의 일련의 행동)를 모두 수행한 후, 얻은 총 보상(reward)을 기반으로 정책의 파라미터를 조정합니다.

- 기본 아이디어: 좋은 결과(높은 보상)를 가져온 행동은 더 자주 선택되도록 정책을 강화하고, 나쁜 결과는 그 확률을 줄입니다.

특징

- 간단하고 직관적이지만, 에피소드 전체를 기다려야 업데이트 가능.

- 보상의 분산이 크면 학습이 느리고 불안정할 수 있음.

활용 사례

- 간단한 게임(예: 카트폴 게임)에서 초기 정책 학습 실험에 사용.

2. Actor-Critic 방법

원리

- Actor(행위자): 정책 πθ(a∣s)\pi_\theta(a|s)를 출력하여 어떤 행동을 할지 결정합니다.

- Critic(비평가): 가치 함수 Vw(s)V_w(s)를 학습하여 특정 상태의 기대 보상을 추정합니다.

- 업데이트: Critic이 상태의 가치(V)를 평가하고, Actor는 이 평가를 바탕으로 정책을 조금씩 개선합니다.

- TD(Temporal Difference) 방식: 매 에피소드가 끝나지 않아도 매 스텝마다 업데이트가 가능합니다.

특징

- 샘플 효율성이 높아 빠른 학습이 가능.

- Actor와 Critic 모두 별도의 신경망으로 구성.

- 안정성을 높이기 위해 다양한 개선 기법(A2C, A3C 등)이 제안되었습니다.

활용 사례

- 로봇 제어, 자율 주행, 복잡한 게임(예: Atari 게임) 등 다양한 환경에서 사용.

3. PPO(Proximal Policy Optimization)

원리

- 정책 업데이트 시 "너무 큰 변화"가 일어나면 성능이 오히려 떨어질 수 있음을 해결하려고 개발.

- 기존 정책과 새 정책이 크게 달라지지 않도록 제약을 두고 조금씩 업데이트합니다.

- 클리핑(Clipping) 방법을 도입하여 안정적인 학습을 유도.

- 수식 개요: 기존 정책 대비 새 정책이 너무 다르면 손실(Loss)을 제한(clamp)하는 형태.

특징

- 안정성과 성능이 뛰어나 실제 환경 적용에 적합.

- 하이퍼파라미터 튜닝이 비교적 쉽고, 널리 쓰이는 표준 강화학습 기법 중 하나.

활용 사례

- OpenAI의 로봇 팔 제어, OpenAI Five(도타2 AI 팀) 등에 사용.

정책 경사법(Policy Gradient) 세부 알고리즘 특징 비교

| 알고리즘 | 특징 | 대표 활용 |

| REINFORCE | 단순하고 직관적이지만 느림 | 초급 강화학습 실험 |

| Actor-Critic | 빠른 업데이트 가능, 효율성 높음 | 로봇 제어, 게임 AI |

| PPO | 매우 안정적이고 고성능 | 실제 제품용 AI(자율주행, 로봇 등) |

'인공지능의 발전 > 머신러닝의 부상' 카테고리의 다른 글

| 딥러닝과 강화학습의 결합 (2) | 2025.05.01 |

|---|---|

| 액터-크리틱(Actor-Critic) 구조 (0) | 2025.04.29 |

| Q-러닝(Q-Learning) (0) | 2025.04.29 |

| 시간차 학습(TD Learning) (0) | 2025.04.28 |

| 벨만 방정식(Bellman Equation) (1) | 2025.04.28 |